ChatGPT 流行之后,越来越多的人把 ChatgPT 当做搜索引擎来使用。本文从产品设计角度,解释这个现象背后的原因,以及它对产品设计的影响。

我以前有外号叫“人头Google脑”,手机能上网之前我就有“立刻Google一下”的名声,而且我还“代客 Google”帮人搜索💪

某次在南锣鼓巷,某路人盯着电线杆喃喃自语:你说电线杆顶上那个橙色小风车是干嘛用的?我琢磨好久也没想明白。

那位长了一张自视甚高的知识分子脸,一看就是网上什么话题他都要驳斥的那种。他当时还斜着眼睛瞟我,不知道算是自问还是设问还是挑战我。

我随口回答:为了驱鸟。

他就震惊了😆

关键词搜索 vs 自然语言提问

并非我牛逼,其实是因为我以前 Google 过这个“小风车”问题。

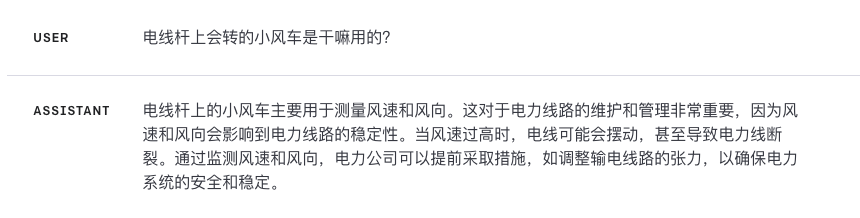

谷歌为代表的传统搜索引擎以搜索关键词为基础,当时(200X年)它很难理解“电线杆上会转的小风车是干嘛用的?”这种句子,所以我用不同方法搜了好几次,才得到结果。

之所以我利用搜索引擎的能力远超一般人,因为我理解搜索引擎的工作原理,因此搜索时能熟练而高效地选择合适的关键词,并用 Google 的搜索语法来提高搜索质量。比如我用 Google 来搜索这个电线杆上的小风车,搜索关键词大约是:电线杆 橙色 镜子 风车 -发电。

相反,一般人缺乏电脑常识,下意识地会用问问题的方式使用搜索引擎。如果你直接问谷歌“电线杆上会转的小风车是干嘛用的?”这种自然语句的长问题,多数情况下谷歌并不理解你到底在问什么,所以它会把你的句子拆分成关键词、再去搜索。这么搜索出来的结果往往过于宽泛,让人非常失望。

ChaGPT 这种基于 LLM 大数据模型的 AI,一大特色就是能够理解用户的提问:

- 非但能理解字面的意思,还能根据提问的上下文来理解用户的言下之意、真实意图

- 如果用户对 ChatGPT 的提问不太满意,还能继续追问它

- ChatGPT 的手机 APP 还自带了语音识别功能,可以直接开口说话问它

这种自然语言式的提问,这种基于对话的互动方式,都为用户带来极大便利,自然会被用户追捧。

罗列几十页结果 vs 直接给出答案

为什么很多人抛弃了谷歌、百度,而改成在小红书上提问?或者发推文问“万能的推特”?

因为小红书和推特给出的结果很少,要么随便翻翻就看到了、要么直接就回答了问题。这种直接了当避免了大量的体力活,像百度、谷歌那种动辄几十、几百页答案,看着就晕,而且每个答案还得点开看网页,才有可能找到答案。

这就凸显了 ChatGPT 另一个深受喜爱的特点:直接给出答案,没有百度、谷歌那么复杂而漫长的搜索过程。

今天的百度、谷歌会在搜索结果页里先列出一个优选答案,早年流行的 Siri、Alexa、小爱同学之类的 AI 语音助理,接受提问时也能直接给出一个答案。不过它们的智能水平相对有限,给出的答案看起来不是那么可信。

相对的可信 vs 假装的可信

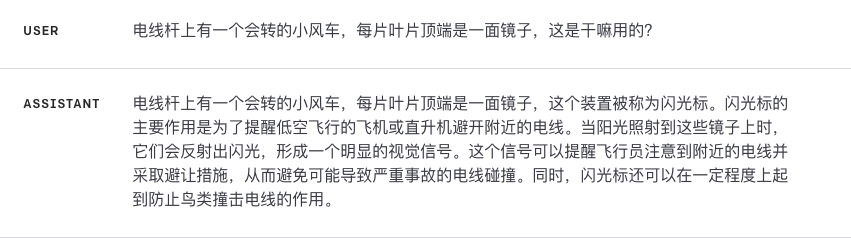

今天我们可以随意向 ChatGPT 问“这个”小风车”问题,它会瞬间给出一堆看似正确的答案。

其实狗屁! 它不知道那个小风车是什么。

既然 GPT-4 已经发布了几个月(这在 LLM 的 AI 世界里差不多等于上世纪吧?),我顺便也来测试一下 GPT-4 怎么回答这个“小风车”问题。

它的回答有时候似乎很正常(图一),有时候似乎不正常(图二),有时候似乎极其正常(图三、图四)。如果我预先不知道正确答案,我会认为它们说得都很有道理!

ChatGPT 刚开始流行时,很多段子的主题都是 ChatGPT 不切实际的盲目自信,以及立刻认错、立刻改口、继续扯淡的搞笑“人格”。但随着 ChatGPT 用户越来越多,反而有更多人盲目信赖 ChatGPT、不再抱怨它的准确性。

有各种研究文章讨论这种现象,这里就不展开讨论了。用普通话简述一下,我们轻信 ChatGPT 的原因大概有几种:

- 它的回答看起来太靠谱了

- 它的回答超出了我们的认知范围,我们无法判断它的是否真实、可信

- 我们在工作和学习里直接引用 ChatGPT 的回答,一直没有出错

ChatGPT “搜索”能力对产品设计的影响

ChatGPT 等 LLM 大语言模型 AI 都善于“搜索”和回答问题,简述一下这种能力对产品设计的影响,以及应对思路。

ChatGPT 们改变了“搜索”的产品设计

Bing 已经整合了 ChatGPT,既能用 ChatGPT 把用户的自然语言提问转化为搜索关键词、优化搜索引擎的输入,也能用自然语言描述更直接、更人性化的搜索结果,这优化了搜索结果的输出,当然 Bing 还能直接使用 ChatGPT 回答用户问题、把搜索引擎作为参考资料。

今后的搜索体验,会越来越多地结合 ChatGPT 们的自然语言交互能力和直接回答问题的能力。这种体验不限于搜索引擎以及知识库、问答、客服等等以搜索为主的产品,普通的产品中也会集成 ChatGPT 或者专用 LLM 模型,利用它们更好地与用户交互、更有效地输出结果。

特别是语音识别和语音合成技术的效果越来越好,理论上每个软件、APP、网站都可以自带一个高智商的 Siri,无论是实现基本产品功能,还是额外地增加营销、客服功能,这些新一代的 Siri 都能改善产品的整体使用体验。

现阶段“多模态”的 LLM 大语言模型还没有普及,按照现在的 AI 模型发展速度来推理,ChatGPT 们很快能普及搜索图片、语音、视频的能力,这又是另一个维度的可能性。

ChatGPT 干掉了 Stack Overflow 等人工回答

Stack Overflow、Quora 以及知乎这样的知识分享社区、问答社区,由用户来回答用户的问题。ChatGPT 这样的大语言模型对这类网站造成了极大的冲击。

以程序员问答社区 Stack Overflow 为例,按照 Business Insider 引用 Stack Overflow 自己的数据,2023 年四月,Stack Overflow 的流量相比 2022 年同期下降了 13%(来源)。这是不是预示着人类回答的消退?

既是也不是。

一方面,各个垂直领域的专业人士、比如像我这样的的设计专家,或者生活中的达人、比如我这样的“人头Google脑”式的智慧达人,这些人的智慧并不会被 ChatGPT 削弱。相反,这些专家和达人能利用 ChatGPT 来强化自己的知识检索、整理和输出能力。

ChatGPT 替代的是泛泛的、针对性不强的回答。

另一方面,ChatGPT 强大无比的撰写能力、创造能力,以及超出大多数人的语言组织能力、表达能力,让普通人也能创造出看似专业的内容。这些制造出来的劣质内容会直接拉低 Stack Overflow、Quora 以及知乎的内容质量。

知乎推出了 AI 写作工具,那么知乎内部有没有对等的 AI 防作弊工具、AI 内容过滤工具?这种评判,可不是雇佣一堆数据标注工人就能搞定的。

规避 ChatGPT 可信度的问题

ChatGPT 在不同领域回答问题的可信度不一而论,整体而言,现阶段 ChatGPT 的回答属于看似靠谱、其实并不靠谱。

用户对 AI 产品的态度也各不相同,比如:

- 深信。利用 GPT 和 Whisper 等技术创造的文字翻译、字幕翻译、英语口语教练等等工具,多半属于这个范畴。这里其实利用了用户无法判别错误、感知错误的漏洞,或者说用户和 ChatGPT 之间的认知差

- 半信半疑。类似 ChatPDF 的很多产品,利用 ChatGPT 来阅读长文、生成摘要、研究文章中的要点等等。浅层次使用时,这些工具方便而有效,但到了深层次使用阶段,用户就需要额外花费时间去判别工具的输出信息

- 不信。在法律、医学等专业领域,ChatGPT 们的回答准确性就无从谈起了。所以会有专业领域模型、Fine-tuning 和 Embedding 之类的技术手段,来开发更专业的“ XYZ GPT”。

包括 OpenAI 在内的 AI 专业人士,已经提出了多种提高 ChatGPT 准确性的方法。普通用户也能通过更好的 prompt,来从 ChatGPT 获取更准确的回答。

从产品设计角度而言,怎么向用户展示 ChatGPT 等 AI 的可信度,直接影响了用户体验和用户对产品、对品牌的信任度。最底线的做法是:在 AI 准确度、可信度的问题上,也许你可以某种形式地误导用户,但绝对不要欺骗用户。

我相信 AI 的发展速度,一直会优于人类搜索信息能力的进化速度,只要借助 AI 工具,以后菜场大妈也能立刻回答“电线杆上会转的小风车是干嘛用的?”。

这种随时随地准确获取信息的能力,将成为以后人类的基本功能😂